La révolution de l’intelligence artificielle a radicalement transformé la manière dont nous produisons, consommons et partageons des contenus visuels. Parmi les innovations les plus marquantes, la capacité à générer des images réalistes de personnalités publiques (politiques, artistes, sportifs) suscite à la fois fascination et inquiétude. Cette technologie, portée par des outils générant des images (Midjourney, ChatGPT, HeyGen…) rend possible les deepfakes. Elle soulève des questions cruciales : peut-on encore distinguer le vrai du faux ? Comment protéger le droit à l’image et prévenir les abus ? Faut-il interdire purement et simplement l’utilisation de ces outils pour créer des images de personnalités connues (hors contrat) ?

Cet article explore les enjeux de cette problématique, en s’attardant sur la lutte contre les fake news, la distinction entre satire et désinformation, et les défis pratiques liés à une telle interdiction. Enfin, nous discuterons des alternatives possibles, combinant régulation, éducation et innovation technologique.

1. Enjeux de l’interdiction

1.1. La lutte contre les fake news

Les fake news visuelles sont devenues un outil puissant de désinformation. À l’aide d’outils génératifs, il est désormais possible de créer des images hyperréalistes de célébrités ou de personnalités politiques dans des situations fictives. Par exemple, des images falsifiées d’un dirigeant politique en situation de corruption ou d’un artiste impliqué dans un scandale peuvent rapidement devenir virales, influençant l’opinion publique avant que la vérité ne soit rétablie.

Avec l’essor des outils open source, accessibles même à des amateurs, la création de ces images est devenue plus facile que jamais. Pire encore, les plateformes hébergeant ces contenus peinent à modérer efficacement les publications, amplifiant leur diffusion.

1.2. La protection du droit à l’image

Le droit à l’image, essentiel pour protéger la vie privée et la réputation, est mis à rude épreuve par ces nouvelles technologies. Les personnalités publiques, bien que souvent habituées aux critiques et aux détournements, peuvent voir leur image utilisée dans des publicités ou même de manière nuisible. Dans certains cas, les conséquences vont au-delà des atteintes morales : perte de contrats, atteinte à leur crédibilité, voire préjudices financiers.

Par exemple, des deepfakes montrant un acteur ou un chanteur dans une vidéo explicite ou compromettante peuvent nuire durablement à leur réputation, même après démenti. Des campagnes de phishing utilisant des deepfakes de Jean Pierre Pernaut ou Jean Jacques Goldman ont ainsi été diffusées sur les réseaux sociaux afin d’escroquer leur public. Les recours juridiques, bien qu’existants, sont souvent lents et inefficaces face à la viralité des contenus numériques.

1.3. Les limites des solutions techniques

Des solutions techniques comme le watermarking (intégration de filigranes invisibles sur les images générées) ou les détecteurs de deepfakes sont souvent évoquées comme alternatives. Cependant, leur efficacité est très limitée. Les modèles maison ou open source contournent aisément ces protections. De plus, les détecteurs d’images falsifiées, bien qu’efficaces dans des environnements contrôlés, peinent à suivre les avancées rapides des technologies de génération.

2. Satire vs fake news

2.1. Définition de la satire

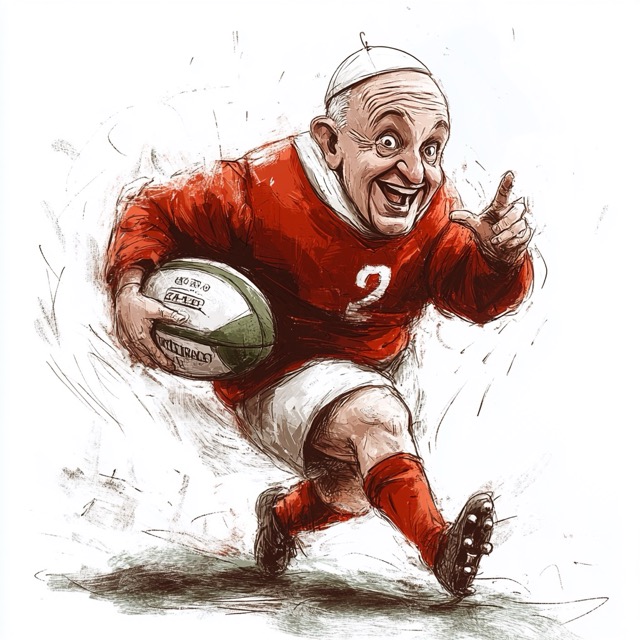

La satire est une forme d’expression artistique et culturelle essentielle pour critiquer la société et les figures publiques. Historiquement, les caricatures et parodies ont joué un rôle majeur dans le débat public, offrant un espace à l’humour et à la critique.

À titre d’exemple, les caricatures politiques dans des journaux comme Charlie Hebdo ou les vidéos humoristiques imitant des discours de dirigeants sont des formes de satire largement acceptées et protégées par le droit à la liberté d’expression.

2.2. Les frontières floues avec les fake news

Cependant, la frontière entre satire et désinformation est souvent mince. Une image humoristique ou exagérée peut facilement être mal interprétée comme une information véridique. Par ailleurs, des créateurs mal intentionnés peuvent masquer leurs fake news sous l’apparence de satire, rendant difficile l’évaluation de leur intentionnalité.

Interdire la génération d’images sans distinction pourrait entraîner une censure excessive, menaçant la liberté d’expression et les formes légitimes de critique sociale.

3. Défis pratiques de mise en œuvre

3.1. Identification des auteurs

L’un des principaux obstacles à une interdiction stricte est l’anonymat sur Internet. Les créateurs de contenus générés par l’IA peuvent facilement se cacher derrière des pseudonymes ou opérer depuis des juridictions qui ne sanctionnent pas ce type de pratiques.

De plus, la traçabilité des outils utilisés (modèles maison ou open source) est presque impossible. Même si les grandes entreprises technologiques imposent des restrictions, des alternatives non régulées continueront d’exister.

3.2. Circulation des modèles open source

Les modèles génératifs open source, comme ceux proposés par des plateformes collaboratives, échappent souvent à toute forme de contrôle. Ils circulent et deviennent de plus en plus populaires et simples à installer / utiliser. Ces modèles peuvent être modifiés ou réentraînés pour produire des images non conformes aux réglementations.

3.3. Coopération internationale

Réguler efficacement cette technologie nécessiterait une harmonisation juridique à l’échelle mondiale. Cependant, les divergences culturelles et législatives entre les pays compliquent cette coopération. Par exemple, une image interdite dans un pays peut être considérée comme légitime dans un autre.

4. Alternatives à une interdiction totale

4.1. Régulation stricte des outils propriétaires

Une alternative à l’interdiction serait d’imposer des règles strictes sur l’utilisation des outils génératifs mainstream. Cela inclurait :

• Sanctions pour les abus : Amendes ou peines de prison pour les créateurs de contenus nuisibles ? Un point à travailler en droit afin d’intégrer la législation actuelle sur le droit à l’image. Sachant que le volume de deepfake générés limite l’intervention de la justice, on ne peut traiter au tribunal que les cas les plus graves.

• Responsabilisation des plateformes : Logiquement un réelle obligation pour les plateformes de détecter et supprimer ces contenus illicites. En se basant sur la distinction caricature / deepfake les rendus photoréalistes de personnes existantes peuvent être bloqués. Les plateformes sont les seules à avoir les moyens techniques de le faire, même si cela va à l’encontre de leurs priorités. En effet les deepfakes et les contenus choquants génèrent des clics, et donc des revenus.

Si elle ne bloque pas tous les abus, ces options vont rendre plus difficile la génération de fake news.

4.2. Développement de certifications des contenus authentiques

Je n’ai jamais cru que le watermarking des image générées serait suffisant car il peut être contourné. A défaut on peut faire le contraire. Des certifications pourraient être mises en place pour identifier les contenus authentiques. Par exemple, un filigrane obligatoire, facilement identifiable par les utilisateurs, pourrait être imposé à des fins de certification des contenus authentiques. Ce processus consisterait à apposer un sceau numérique ou un filigrane sur les images et vidéos vérifiées, attestant de leur origine et de leur authenticité. Des technologies comme la blockchain pourraient être mobilisées pour créer des registres immuables, permettant de tracer l’origine des fichiers multimédias et de garantir leur intégrité.

En parallèle, des outils standardisés de vérification, intégrés aux appareils photo, aux logiciels de création et aux plateformes de diffusion, pourraient assurer que les contenus publiés respectent ces normes de transparence. Cette approche aurait également pour avantage de responsabiliser les créateurs et les diffuseurs, tout en offrant au public un moyen clair de distinguer les images authentiques des deepfakes ou autres manipulations.

Cependant, pour être efficace, un tel système de certification nécessiterait une adoption large et une coopération internationale, afin d’assurer une compatibilité universelle et une lutte globale contre la désinformation visuelle. C’est peut-être là que ce situe le principal obstacle sachant que certains pays font des deepfake une arme de déstabilisation.

4.3. L’éducation numérique rempart contre la désinformation

L’éducation numérique joue un rôle fondamental dans la lutte contre les abus liés aux images générées par l’intelligence artificielle. Si des technologies comme les détecteurs de deepfakes ou les certifications de contenu sont des solutions techniques prometteuses, elles ne peuvent être pleinement efficaces sans une population informée et consciente des risques associés à ces outils.

Apprendre à repérer les manipulations

La première étape consiste à enseigner au public comment identifier les signes de manipulation dans les images et les vidéos. Bien que les deepfakes les plus sophistiqués soient difficilement détectables par l’œil humain, de nombreux contenus générés présentent des anomalies flagrantes comme des ombres incohérentes, des mouvements faciaux rigides ou des artefacts visuels. Une sensibilisation à ces indices peut aider les individus à développer un esprit critique face aux contenus qu’ils consomment.

Comprendre les mécanismes de désinformation

L’éducation numérique doit également inclure une compréhension des stratégies utilisées pour propager les fake news. Cela implique de former les citoyens à analyser les sources d’information, à vérifier les faits à l’aide de plateformes de fact-checking, et à réfléchir à la manière dont les images manipulées peuvent être utilisées pour influencer leurs opinions ou leurs émotions.

Former dès le plus jeune âge

Pour un impact durable, ces compétences doivent être intégrées dans les programmes éducatifs dès l’école. Initiatives scolaires autour de la culture médiatique, ateliers sur la vérification des informations en ligne, ou modules sur l’utilisation responsable des outils numériques peuvent armer les jeunes générations face aux défis posés par la désinformation visuelle.

Renforcer les compétences des professionnels

Les journalistes, enseignants, et décideurs politiques doivent également être formés à utiliser les technologies de détection et à interpréter les contenus numériques avec discernement. En renforçant leur expertise, ces professionnels peuvent devenir des relais fiables pour informer et éduquer la population.

Promouvoir une culture de responsabilité collective

Enfin, l’éducation numérique doit encourager une culture de responsabilité collective sur Internet. Cela inclut la promotion d’un comportement éthique en ligne, comme éviter de partager des contenus douteux sans vérification préalable, et signaler les abus aux plateformes concernées.

En développant ces compétences et en favorisant une prise de conscience généralisée, l’éducation numérique peut devenir un véritable rempart contre les abus liés à la génération d’images par IA. Si la technologie évolue rapidement, la capacité des individus à l’utiliser de manière critique reste une arme clé pour préserver un écosystème numérique sain et respectueux.

4.4 S’appuyer sur la différence de forme entre une caricature et un deepfake

La distinction entre une caricature et un deepfake repose principalement sur leur forme et leur intention visuelle. Une caricature, qu’elle soit dessinée ou numérique, accentue volontairement les traits physiques, les expressions ou les comportements de manière humoristique ou satirique, rendant immédiatement évident son caractère irréaliste. Par exemple, un dessin politique exagérant un nez proéminent ou une posture caractéristique d’une figure publique ne cherche pas à tromper mais à faire passer un message critique ou comique.

En revanche, un deepfake est conçu pour simuler le réel avec une précision trompeuse. À l’aide de technologies avancées, il recrée des visages et des voix avec un réalisme bluffant, rendant difficile pour un spectateur moyen de discerner la manipulation. Alors que la caricature repose sur l’exagération et l’invitation à la réflexion ou au rire, le deepfake joue sur la crédibilité et vise à imiter le réel, ce qui le rend dangereux lorsqu’il est utilisé à des fins malveillantes.

Accentuer la caricature permet d’éviter toute confusion. En théorie car certaines publications du Gorafi (site caricatural) ont déjà été reprises comme de vraies infos sur les media sociaux.

5. Des solutions hybrides et collectives

Si les technologies génératives ouvrent des perspectives passionnantes, elles posent aussi des risques considérables, notamment pour la désinformation et le droit à l’image. Une interdiction totale de la génération d’images de personnalités publiques pourrait résoudre certains problèmes, mais risquerait aussi de restreindre des usages légitimes, comme la satire ou l’art.

Plutôt qu’une interdiction, une approche équilibrée mêlant éducation, régulation, responsabilisation des plateformes, innovation technique et éducation semble être la meilleure voie.

À mesure que la technologie évolue, la responsabilité des entreprises, des gouvernements et des citoyens sera essentielle pour créer un écosystème numérique éthique respectueux des libertés et des personnes.