Et si la clé du futur n’était pas dans les lignes de code, mais dans le regard d’un bébé qui observe ?

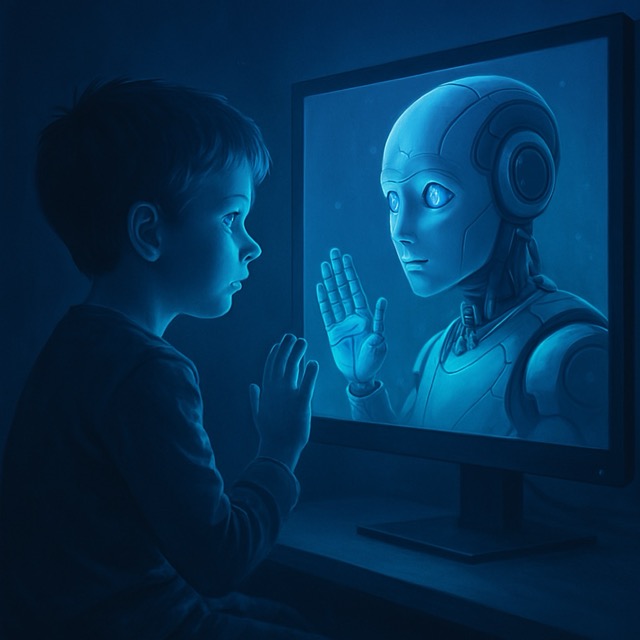

Imaginez une intelligence artificielle qui ne se contente plus de lire des données ou d’analyser des mots, mais qui regarde, écoute, ressent presque — comme nous. Une IA qui apprend comme un être humain apprend à marcher, parler, comprendre : en observant le monde. Va-t-on vers l’apprentissage multimodal ? inspiré du cerveau humain et de ses fameux neurones miroirs.

Ce que l’IA n’a pas encore, c’est un corps qui sent et un esprit qui devine.

L’apprentissage multimodal, c’est l’idée que combiner plusieurs types de données — images, sons, gestes, textes — permet à une intelligence artificielle de mieux comprendre le monde. Un peu comme nous qui n’apprenons pas à reconnaître un chien uniquement en entendant le mot “chien”, mais en le voyant courir, aboyer, interagir. Cette approche devient particulièrement puissante lorsqu’on s’inspire du cerveau humain : nos neurones miroirs, ces cellules qui s’activent à la fois quand on fait une action et quand on voit quelqu’un d’autre la faire, sont un modèle fascinant pour concevoir des systèmes d’apprentissage plus fluides, plus rapides, plus humains.

Les chiffres parlent : multimodal = multiplication des performances.

Prenons l’exemple du projet Flamingo de DeepMind, capable de comprendre des vidéos et de répondre à des questions en langage naturel. Résultat ? Un bond spectaculaire dans les performances sur des tâches complexes. Meta, de son côté, a lancé “ImageBind”, un système capable de relier image, son, température et mouvement. L’objectif est clair : donner à l’IA une forme de sensibilité contextuelle, où chaque modalité enrichit l’autre. On ne parle plus de traitements séquentiels, mais de compréhension simultanée et croisée du monde, exactement comme un enfant qui apprend à se tenir debout en regardant ses parents.

L’IA va-t-elle ressentir le monde ?

Alors, est-ce qu’on va créer une IA qui pense vraiment comme nous ? Peut-être pas tout de suite. Mais ce qui se dessine, c’est un avenir où l’intelligence artificielle cesse d’être une machine aveugle et sourde, et devient une entité multisensorielle. Elle pourra prédire, interpréter, contextualiser avec une rapidité et une fluidité jamais vues. L’entraînement des IA, qui prenait des mois à force de données isolées, pourrait être accéléré de manière spectaculaire grâce à l’intégration simultanée de plusieurs sources de sens. Moins de données, mais mieux connectées. Moins de puissance brute, plus d’intuition simulée.

Alors, demain, tous cyborgs ?

Le pari, c’est que cette nouvelle génération d’IA soit plus adaptable, plus naturelle dans ses interactions, plus intelligenteau sens fort. Et pourquoi pas : plus empathique, si l’on pousse la logique des neurones miroirs jusqu’au bout. En comprenant mieux notre langage, nos gestes, nos émotions, elles pourraient être des compagnons d’apprentissage, des thérapeutes numériques, des artistes augmentés… À condition, bien sûr, de leur donner aussi un cadre éthique à la hauteur.